推理大爆炸:国内推理模型的阶段性介绍、汇总、分析与思考

01

新春之际,大模型厂商抢着提前回家过年,有Kimi与DeepSeek在同一天发布对标o1的推理模型。在这之前,还有许多类o1推理模型。

本文探索国产推理模型的发展与思考。

02介绍部分类o1推理模型的核心技术。

03梳理能够对标o1-preview、o1-mini或o1正式版的模型,简要介绍其技术或工程创新之处。

04结合思考,窥探模型发展新格局。

02 部分核心技术

思维链(Chain of Thought, CoT):

思维链是一种帮助大模型进行推理的技术。其核心思想是通过让模型在回答复杂问题时,逐步解释每一步的推理过程,而不是直接给出答案。

强化学习(Reinforcement Learning, RL):

强化学习是一种通过与环境交互来学习最优行为的机器学习方法。模型通过试错来学习,根据环境的反馈(奖励或惩罚)来调整其行为,以最大化累积奖励。

多阶段训练流程

多阶段训练流程是一种分阶段进行模型训练的方法,通常包括预训练、微调和强化学习等阶段。每个阶段都有特定的目标和方法,通过逐步优化模型的性能。

在类o1推理模型中,多阶段训练流程被用来确保模型在不同阶段都能达到最佳性能。

在此说明,大语言模型(LLM)的训练通常包括预训练、监督微调、奖励建模和强化学习四个阶段,这一流程主要由OpenAI定义。

Kimi K1.5通过预训练、监督微调、长思维链(CoT)监督微调和强化学习四个阶段,实现了推理性能的显著提升。

DeepSeek R1摒弃了拒绝采样和监督微调,仅依靠强化学习进行训练。以往,模型性能的提升往往依赖于大量的监督数据,但DeepSeek R1的训练方式打破了这一传统模式。

03

以下不对模型能力进行比较,推理模型出现顺序按照发布时间排序。

另外,对于推理模型的总结仍有许多遗漏,部分模型没有涉及,如阿里开源推理模型Marco-o1、QwQ、QvQ,微信的DRT-o1等。

需要强调,下面所涉及的模型是25年以来面向公众开放,且市场关注度较高的几款。

Skywork o1:

昆仑万维的 Skywork o1 于2024年11月27日正式启动邀请测试,并于2025年1月6日全面登陆天工网页和APP,向公众免费开放使用。

Skywork O1 采用了天工自研的 Q* 线上推理框架,将大型语言模型(LLMs)的多步推理视作一个启发式搜索问题。

采用模块化的树形结构推理,将模型回答进行自动化分层输出,并在推理过程中穿插反思和验证。

其他技术特点包括推理反思能力训练、推理能力强化学习和推理planning等。

作为国内首款具备中文逻辑推理能力的o1模型,Skywork o1在模型输出上内生了思考、计划、反思等高级能力,实现了推理能力的显著提升,标志着中国在AI领域取得了新的突破。

GLM-Zero:

智谱 GLM-Zero 的初代版本 GLM-Zero-Preview 于2024年12月31日正式上线。

智谱首个基于扩展强化学习技术训练的推理模型。

GLM-Zero 尝试模拟人脑中的反馈和决策系统,通过自我学习、自我反思和自我批评等机制。

具备一定的多模态理解能力。

显著提升了处理专家级任务的能力。

在 AIME 2024、MATH500 和 LiveCodeBench 等权威评测中,GLM-Zero 的表现与 OpenAI 的 o1-Preview相当。

Step Reasoner mini:

阶跃星辰的 Step R-mini 于2025年1月16日正式上线。

Step R-mini通过大规模的强化学习训练,并使用On-Policy(同策略)强化学习算法,实现了“文理兼修”。

在AIME和Math等数学基准测试上,成绩超过o1-preview,比肩OpenAI o1-mini。在LiveCodeBench代码任务上,效果优于o1-preview。

采用慢思考和反复验证的逻辑机制。

坚持模型规模扩展,正在开发更智能、更通用、综合能力更强的Step Reasoner推理模型。

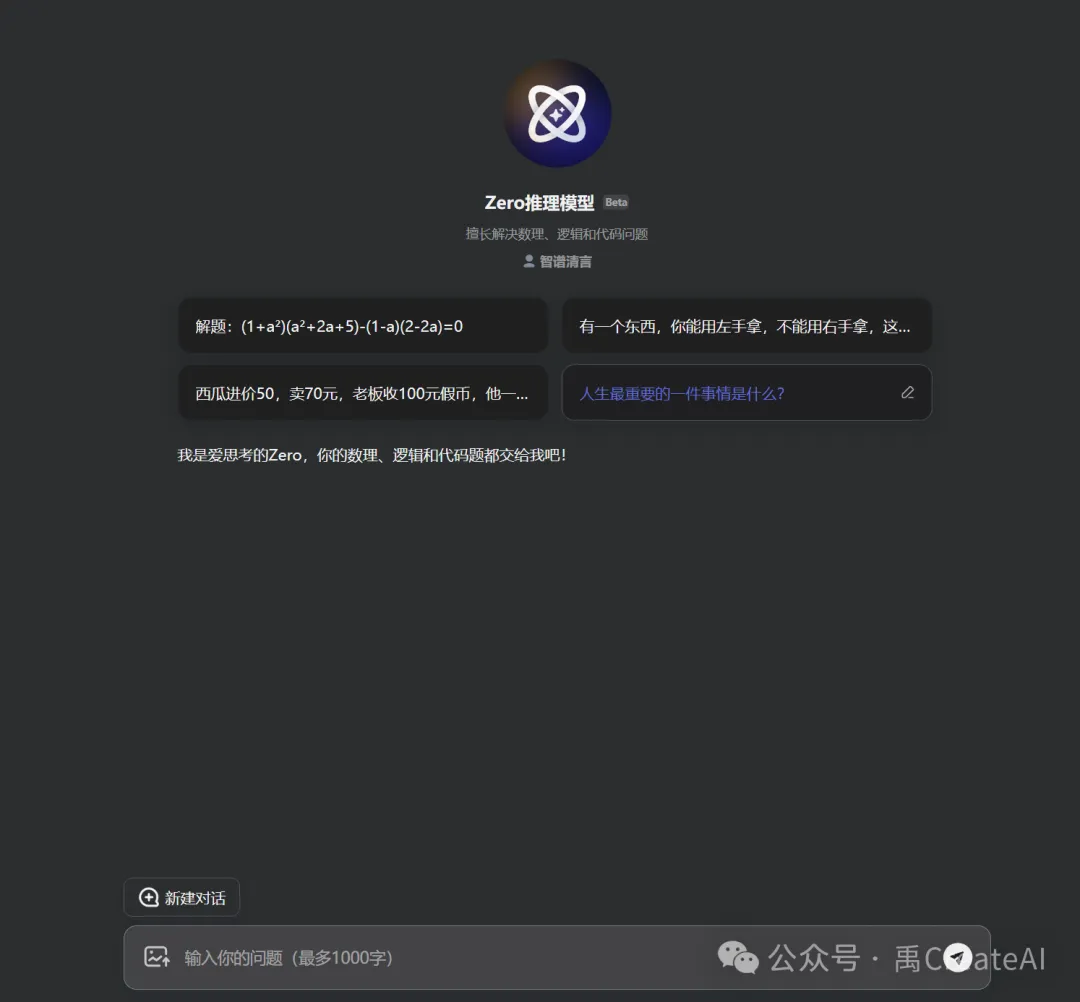

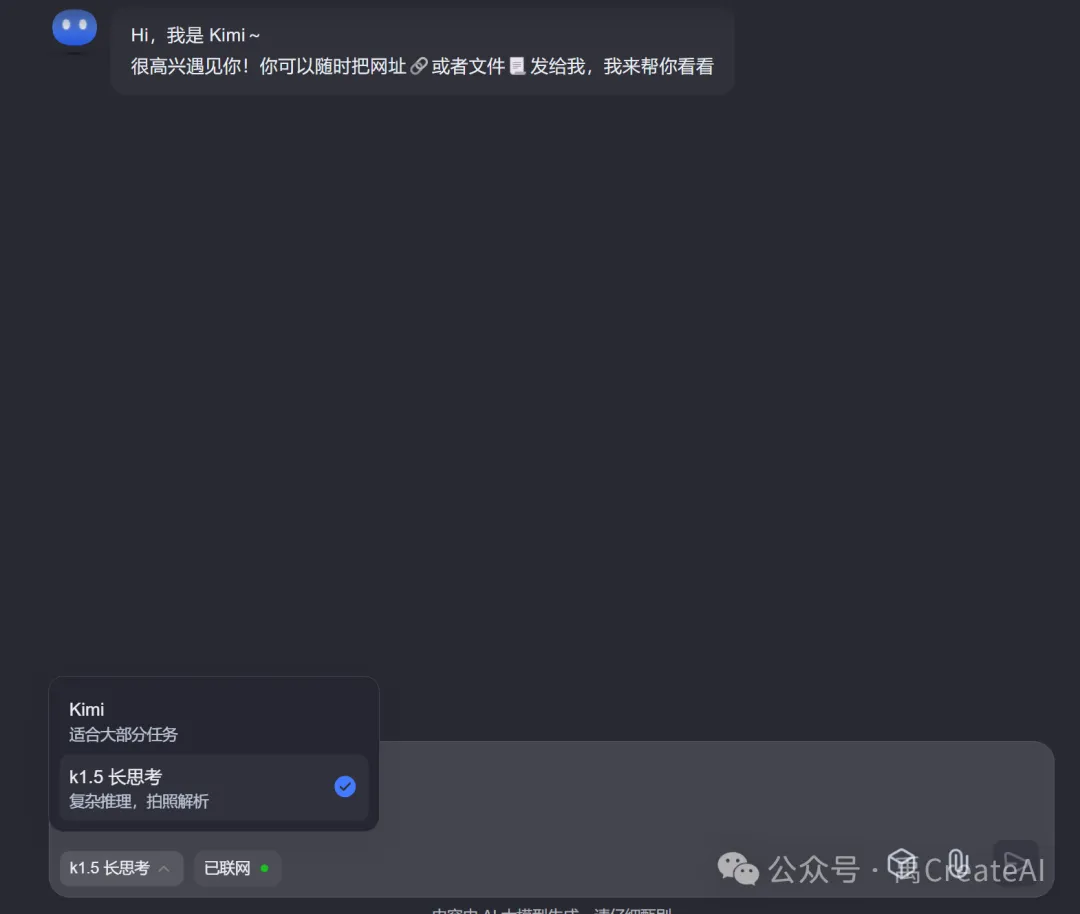

Kimi K1.5:

Kimi K1.5于2025年1月20日正式发布。

Kimi k1.5在数学、代码、视觉多模态和通用能力等方面表现出色,特别是在AIME等基准测试中,其长链思维能力达到了OpenAI o1正式版的水平。

Long2Short训练方案:将长链式思考技术(long-CoT)的优势迁移到短链式思考模型(short-CoT)中,通过长上下文扩展(将强化学习(RL)的上下文窗口扩展到128k)和策略优化改进,进一步优化模型性能。

Kimi k1.5在多个基准测试中表现出色,特别是在short-CoT模式下,其数学、代码、视觉多模态和通用能力大幅超越了全球范围内短思考SOTA模型GPT-4o和Claude 3.5 Sonnet,领先幅度高达550%。

国产AI大模型在多模态推理和强化学习技术方面取得了重大突破。

DeepSeek R1:

DeepSeek R1于2025年1月20日正式发布。

DeepSeek R1在后训练阶段大规模应用了强化学习技术,无需依赖大量监督微调(SFT)数据,即可显著提升模型的推理能力。

通过强化学习技术,实现了长链推理能力的提升,并通过模型蒸馏技术,将推理能力迁移到小型密集模型中,进一步优化了模型性能。

在数学、代码、自然语言推理等任务上表现卓越,性能直接对标OpenAI的o1正式版,同时价格仅为o1的几十分之一,具有极高的性价比。

关于R1,多说几句。

Sam刚刚发了推文正面回应:

1月27日,据Information网站,Meta被曝组建 4 个小组专门研究DeepSeek 模型。

1月27日夜间,DeepSeek 暴击华尔街,欧美科技股市值或蒸发 1.2 万亿美元北京时间。英伟达股价下跌16.97%。市场分析认为,此次美国股市震荡的核心原因是DeepSeek的最新突破,动摇了美国科技行业的地位。

关于R1的一些个人观点,其最大的贡献证明了LLM可以在无监督数据的情况下,通过强化学习提高推理能力。

而至今DeepSeek突然爆火全球的一个根本原因在于他走了真正的”OpenAI“之路。

DeepSeek R1的成功证明,强化学习可以在没有大量监督数据的情况下提升模型的推理能力。这一突破性发现可能会重新定义未来AI训练的方法论,使得AI训练更加高效和经济。

04 思考

个人认为推理模型的爆发不是偶然,而是AI发展的必然阶段。

从”知识型”到”推理型”的转变,AI正在从简单的模式识别向真正的智能思考迈进。推理能力将成为区分下一代AI模型的关键指标。

更为重要的是,当AI Agent爆发成为共识,推理模型无疑为其赋能,我在之前一篇文章提及与分析(从Google与Anthropic看2025 Agent势不可挡的爆发——AI时代的入口)。

只有具备深度推理能力的模型,才能:理解复杂任务的上下文和目标,制定合理的执行计划,在执行过程中进行实时决策调整,处理意外情况并作出适当反应。

当“星际之门”计划的发布,AI技术竞争已经上升到了国家竞争层面。

国产推理模型的快速发展,特别是DeepSeek R1引发的全球关注,表明中国AI企业已经找到了一条独特的技术路径。

通过创新的训练方法和算法突破,我们有望在新一代AI竞争中占据有利位置。

我的结论:

- 推理能力将成为评价AI模型的核心指标之一

- 强化学习技术将在AI训练中发挥更重要作用

- Agent技术将基于推理能力获得质的飞跃

- 全球AI竞争格局可能因技术创新而重塑

来自AI总结:

本文介绍了国产AI推理模型的发展,重点对标OpenAI的o1模型。

文章提到了一些核心技术,如思维链和强化学习,帮助模型提升推理能力。

列举了几款国产模型,如Skywork o1、GLM-Zero、Step R-mini、Kimi K1.5、DeepSeek R1介绍了它们的技术创新。

其中,DeepSeek R1通过强化学习显著提升了推理能力,引发全球关注。

文章认为,推理能力将成为AI的核心指标,强化学习将发挥更大作用,国产模型的进展表明中国在AI领域取得了重要突破。